Microsoft heeft vandaag beweerd dat het “de meest capabele en kosteneffectieve kleine taalmodellen (SLM’s) heeft uitgebracht”, en zegt dat Phi-3 – de derde iteratie van zijn Phi-familie van kleine taalmodellen (SLM’s) – beter presteert dan modellen van vergelijkbare grootte en een paar grotere.

Een Small Language Model (SLM) is een type AI-model dat is ontworpen om uiterst efficiënt te zijn bij het uitvoeren van specifieke taalgerelateerde taken. In tegenstelling tot Large Language Models (LLM's), die zeer geschikt zijn voor een breed scala aan generieke taken, zijn SLM's gebouwd op een kleinere dataset om ze efficiënter en kosteneffectiever te maken voor specifieke gebruiksscenario's.

Phi-3 is er in verschillende versies, legde Microsoft uit, waarvan de kleinste Phi-3 Mini is, een model met 3.8 miljard parameters dat is getraind op 3.3 biljoen tokens. Ondanks zijn relatief kleine omvang (het corpus van Llama-3 weegt meer dan 15 biljoen tokens aan gegevens) kan de Phi-3 Mini nog steeds 128 tokens aan context verwerken. Dit maakt het vergelijkbaar met GPT-4 en verslaat Llama-3 en Mistral Large qua tokencapaciteit.

Met andere woorden: AI-giganten zoals Llama-3 op Meta.ai en Mistral Large zouden na een lang gesprek of prompt kunnen instorten voordat dit lichtgewicht model het moeilijk begint te krijgen.

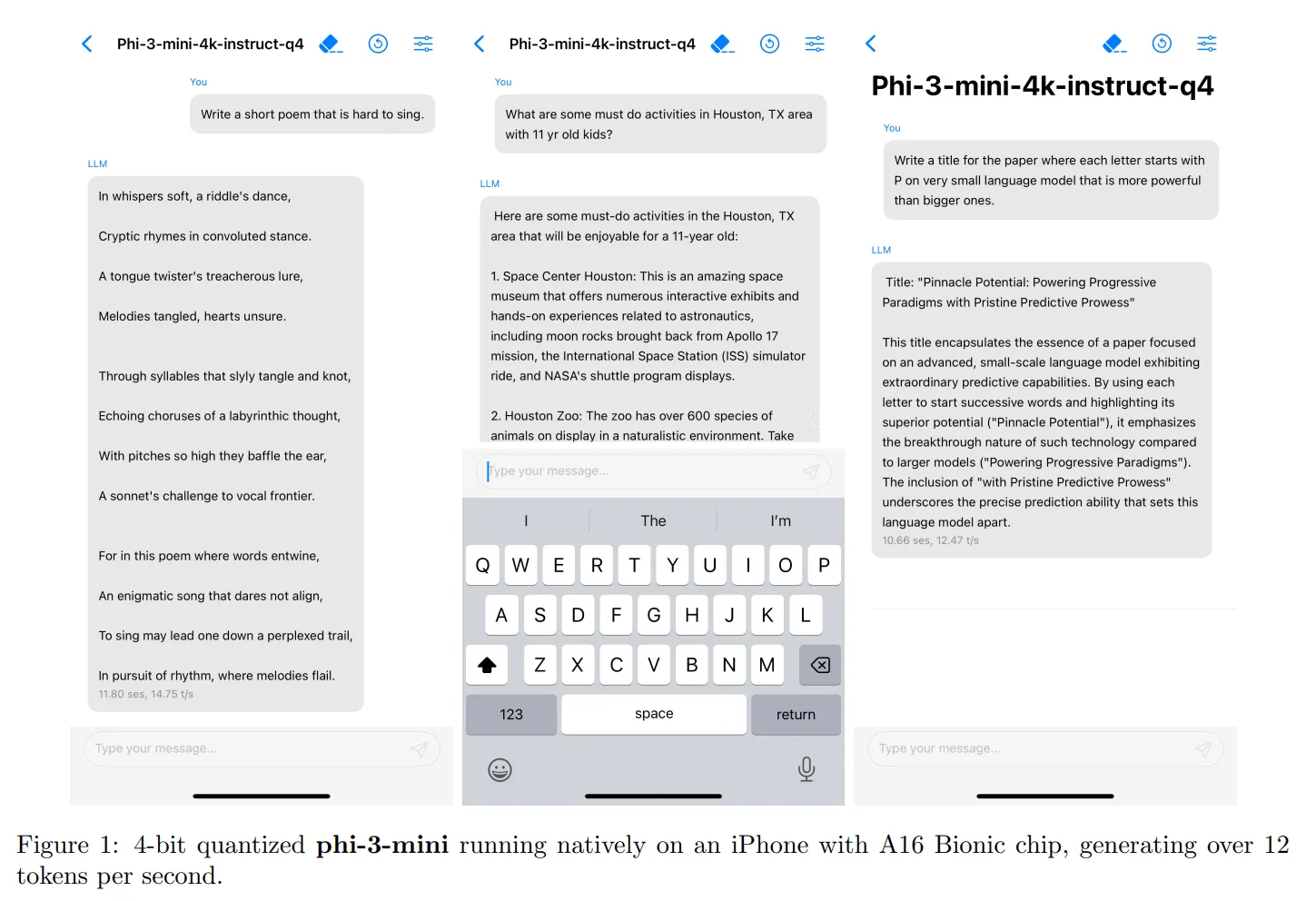

Een van de belangrijkste voordelen van Phi-3 Mini is dat het op een typische smartphone past en werkt. Microsoft testte het model op een iPhone 14 en het werkte zonder problemen en genereerde 14 tokens per seconde. Het uitvoeren van Phi-3 Mini vereist slechts 1.8 GB VRAM, waardoor het een lichtgewicht en efficiënt alternatief is voor gebruikers met meer gerichte vereisten.

Hoewel Phi-3 Mini misschien niet zo geschikt is voor geavanceerde codeerders of mensen met brede eisen, kan het een effectief alternatief zijn voor gebruikers met specifieke behoeften. Startups die een chatbot nodig hebben of mensen die LLM's gebruiken voor data-analyse, kunnen Phi-3 Mini bijvoorbeeld gebruiken voor taken zoals het ordenen van gegevens, het extraheren van informatie, het doen van wiskundig redeneren en het bouwen van agenten. Als het model internettoegang krijgt, kan het behoorlijk krachtig worden en het gebrek aan mogelijkheden compenseren met realtime informatie.

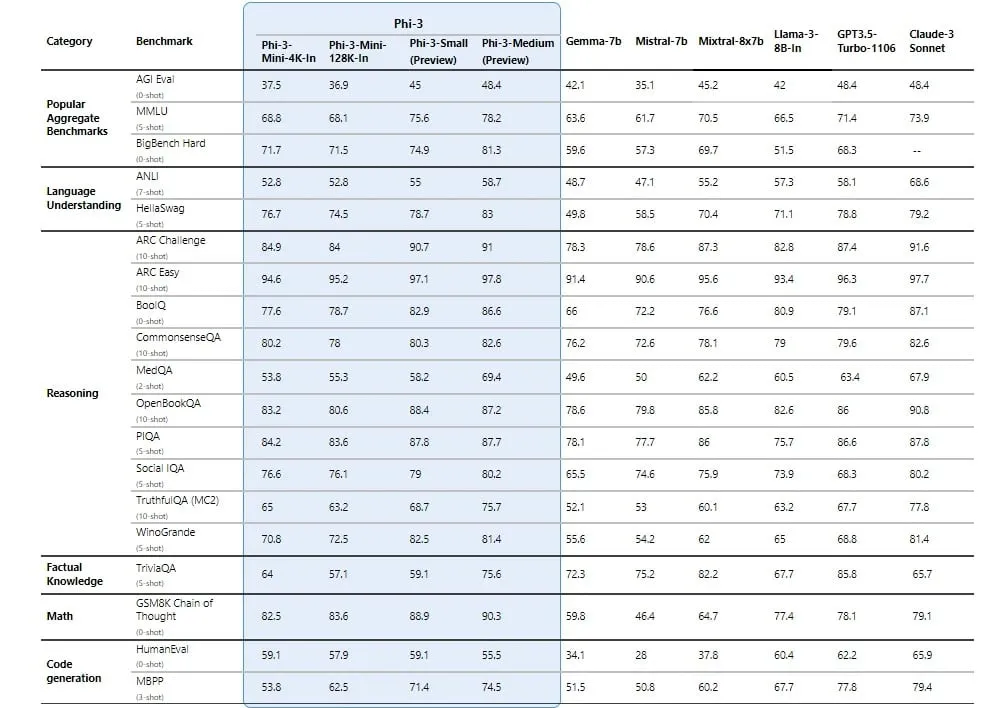

Phi-3 Mini behaalt hoge testscores dankzij de focus van Microsoft op het samenstellen van zijn dataset met de meest bruikbare informatie die mogelijk is. De bredere Phi-familie is in feite niet goed voor taken waarvoor feitelijke kennis vereist is, maar door hun hoge redeneervermogen staan ze boven de grote concurrenten. Phi-3 Medium (een model met 14 miljard parameters) verslaat consequent krachtige LLM's zoals GPT-3.5 – de LLM die de gratis versie van ChatGPT aandrijft – en de Mini-versie verslaat krachtige modellen zoals Mixtral-8x7B in de meeste synthetische benchmarks.

Het is echter vermeldenswaard dat Phi-3 niet open source is zoals zijn voorganger, Phi-2. In plaats daarvan is het een geopend model, wat betekent dat het toegankelijk en beschikbaar is voor gebruik, maar niet dezelfde open source-licenties heeft als Phi-2, wat een breder gebruik en commerciële toepassingen mogelijk maakt.

Microsoft zei dat het de komende weken meer modellen in de Phi-3-familie zal uitbrengen, waaronder Phi-3 Small (7 miljard parameters) en het eerder genoemde Phi-3 Medium.

Microsoft heeft Phi-3 Mini beschikbaar gemaakt op Azure AI Studio, Hugging Face en Ollama. Het model is op instructies afgestemd en geoptimaliseerd voor ONNX Runtime met ondersteuning voor Windows DirectML, evenals platformonafhankelijke ondersteuning voor verschillende GPU's, CPU's en zelfs mobiele hardware.

Blijf op de hoogte van cryptonieuws, ontvang dagelijkse updates in je inbox.

Bron: https://decrypt.co/227974/microsoft-phi-3-mini-small-ai-lingual-model